Inhaltsverzeichnis

Wie es begann

Der erste Versuch, Bilder elektrisch zu übertragen, war eine Kamera mit einer Matrix von Fotozellen (ca. 10*10 Stück) und ein Bildschirm mit ebenso angeordneten Glühlampen. Jede Fotozelle und dazugehörende Lampe bildete einen Stromkreis. Grobe Muster konnten aus diese Weise übertragen werden und die Grundidee, Bilder in einzelne Punkte (Pixel) zu zerlegen und auf Empangsseite wieder zusammenzusetzen, wurde geboren. Schon hier wird also ein Bild in Zeilen zerlegt, die jeweils aus einzelnen Punkten bestehen. Allerdings braucht man so viele Leitungen wie Pixel im Bild, für höher aufgelöste Bilder (heute 720*576) ist das nicht machbar, man bräuchte ein Kabel mit über 400000 Leitungen.

|

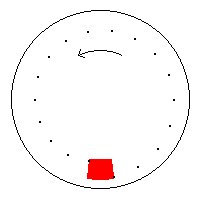

| Nipkowscheibe Schwarz: Komplettes Videosignal Rot: sichtbarer Ausschnitt, sehr klein im Vergleich zur ganzen Nipkowscheibe |

Der nächste Schritt wurde von Paul Nipkow gemacht. Seine Idee ist die sequenzielle Übertragung aller Punkte nacheinander. Dazu verwendete er eine große Scheibe mit spiralförmig angeordneten Löchern auf dem Außenrand. Es waren so viele Löcher wie Zeilen im Bild (es begann mit 30 Zeilen). Am Rand befand sich eine Blende, die einen Kreissektor ausschneidet, der dem Abstand zweier Löcher auf der Scheibe entspricht. Dreht sich die Scheibe, erscheint links oben das erste Loch, das dann nach rechts wandert. Sobald es am rechten Rand verschwindet, erscheint das nächste Loch um ca. eine Lochbreite tiefer und wandert wieder von links nach rechts. Das wiederholt sich so lange, bis das letzte Loch am unteren Rand entlang wandert, danach erscheint wieder das erste Loch links oben. In der Kamera projeziert das Objektiv das Bild auf die Scheibe, dahinter befindet sich eine Fotozelle. Im Empfänger drehte sich ebenfalls eine Nipkowscheibe vor einer Glimmlampe mit leuchtender Fläche, die mit dem verstärkten Signal der Fotozelle gespeist wurde.

Wenn die Scheiben sich synchron drehten, konnte man auf dem Empfänger ein Bild in Briefmarkengröße sehen. Das elektrische Signal der Fotozelle enthält die Helligkeitsinformationen aller Pixel, und zwar zeilenweise nacheinander. Im Prinzip funktioniert das heutige Fernsehen immer noch nach diesem Prinzip, nur das statt der Nipkowscheiben zunächst Röhren verwendet wurden.

In der Kamera hatte man eine Röhre mit einer lichtempfindlichen Schicht, die zeilenweise von einem Elektronenstrahl aufgeladen wurde. Helle Stellen haben sich in der Zwischenzeit seit dem letzen Mal entladen, dunkle nicht. Dadurch schwankt der Strom des Strahles und liefert so das Videosignal. Heute hat man CCD-Chips in der Kamera, da werden durch Ladungsmuster einzelner Potentialtöpfe für jedes Pixel gebildet, die sich je nach Belichtung auf- oder entladen. Nach der Belichtung werden die Pixel zum Rand geschoben und ausgelesen.

In den Fernsehern benutzt man bis heute die Braun’sche Röhre. Ein Elektronenstrahl wird zeilenweise über die Leuchtschicht auf der Frontseite bewegt und dabei mit dem Videosignal in seiner Stärke gesteuert, dadurch entsteht das Bild.

S/W-Fernsehen

Schnell wurde über die Ausstrahlung von Fernsehsendungen nachgedacht. Dazu mußte man sich erst einmal auf eine Fernsehnorm einigen. Zweckmäßigerweise nahm man als Bildwechselfrequenz die halbe Frequenz des Stromnetzes, damit bei den damaligen unvollkommenen Geräten keine Helligkeitsschwankungen durch das Bild laufen (sondern sich nicht bewegen und damit weniger auffallen).

Für die Zahl der Zeilen hat man einen Betrachtungsabstand von etwa der 5-fachen Bilddiagonale angenommen und festgestellt, daß ca. 600 sichtbare Zeilen dann gar nicht mehr unterschieden werden können. Zum Glück war man da ziemlich großzügig mit der Zeilenzahl, sonst würde die Auflösung den heutigen Ansprüchen und Bildgrößen auch mit Linedoubler, progressive Scan und ähnlichen Methoden überhaupt nicht ausreichen.

In Deutschland hatte man dann festgelegt, daß man 25 Bilder/sec. mit 625 Zeilen, davon 575 sichtbar, nehmen wird. 25 Bilder/sec. ergeben zwar eine ausreichend flüssige Bewegung, aber es flimmert doch sehr stark. Im Kino mit seinen 24 Bildern/sec. wird daher jedes Bild zweimal oder sogar dreimal gezeigt (es wird also 48- oder 72-mal pro Sec. abgedeckt, aber nur jedes 2. oder 3. Mal weitertransportiert), wodurch das Flimmern zurückgeht. Beim Fernsehen ist das nicht möglich. 50 Bilder/sec. hätte das Flimmern beseitigt, aber man würde die doppelte Übertragungsbandbreite brauchen. So kam man auf eine Idee, die uns heute immer noch sehr viel Kummer bereitet: den Zeilensprung.

Interlaced Video

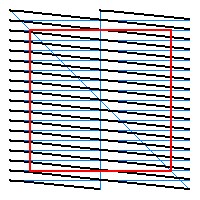

|

| Zeilensprungverfahren Schwarz: Komplettes Videosignal Rot: sichtbarer Ausschnitt Blau: horizontaler und vertikaler Rücklauf |

Die Idee ist folgende: man überträgt zwar 50 Bilder/sec. aber in jedem Bild nur die Hälfte der Zeilen. Diese Bilder nennt man dann Halbbilder oder technisch Fields. Ein Halbbild enthält nur die ungradzahligen Zeilen (Zeile 1,3,5,7,…), das darauffolgende die gradzahligen (2,4,6,8,…). Dem Auge wird nun 50-mal pro Sekunde ein flächiges Bild auf dem Schirm geboten, bei dem allerdings jede zweite Zeile fehlt. Das Großflächenflimmern, auf das das Auge so empfindlich reagiert, ist jetzt mit 50Hz reduziert worden. Da Horizontal- und Vertikalablenkung jeweils mit konstanter Frequenz abläuft und die Zeilen beider Halbbilder ineinandergeschachtelt werden müssen, hat jedes Halbbild 312.5 Zeilen, dadurch erfolgt der Bildrücklauf einmal in der Mitte einer (nicht sichtbaren) Zeile, wodurch die Zeilen beider Halbbilder sich ineinander verzahnen. Wie man sieht, sind die Zeilen nicht exakt waagerecht, beim realen Fernsehen beträgt die Neigung der Zeilen aber nur 0.15° und kann daher vernachlässigt werden. Bei LCD- oder DLP-Projektoren sind die Zeilen exakt waagerecht, aber wegen des kleinen Winkels gibt es trotzdem keine Probleme.

Videosignal und Synchronisation

Vernünftige Bilder entstehen nur dann, wenn die Bewegung der Elektronenstrahlen, die die Pixel in der Kamera abtasten und auf dem Bildschirm schreiben, ständig synchron zueinander ist.

Außerdem muß beachtet werden, daß die Strahlablenkung nicht beliebig schnell an den Anfang einer neuen Zeile oder eines neuen Bildes springen kann. Man hat deshalb folgendes für das Videosignal festgelegt:

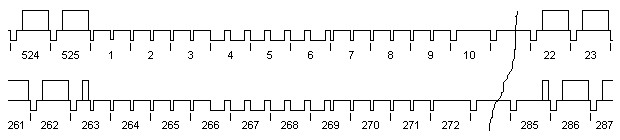

Die Zeilenfrequenz beträgt 625 * 25Hz = 312.5 * 50Hz = 15.625KHz, die Vertikalfrequenz 50Hz. Die Zeilen sind von 1 bis 625 durchnumeriert, Zeile 1 bis 313 (Nr. 313 nur die erste Hälfte) gehört zum ersten Halbbild (dem odd Field), Zeile 313 bis 625 (Nr. 313 nur die zweite Hälfte) gehört zum zweiten Halbbild (dem even Field). odd Field, weil da die ungradzahligen Zeilen des ursprünglichen Bildes drin sind, nicht verwechseln mit der jetzigen Numerierung von 1 bis 625, even Field hat entsprechend die gradzahligen Zeilen).

Im odd Field sind die Zeilen 23 bis 310 sichtbar (Zeile 23 nur die zweite Hälfte), im even Field die Zeilen 336 bis 623 (Zeile 623 nur die erste Hälfte). Die anderen Zeilen enthalten keine Bildinformation, so daß die Ablenkung genug Zeit hat, um am Ende eines Halbbildes wieder nach oben für das nächste Halbbild zu gelangen.

Eine Zeile dauert 64µs (1/15625Hz = 64/1000000 sec.). Davon sind 52µs sichtbar, die restlichen 12µs enthalten keine Bildinformation und geben der Ablenkelektronik Zeit, um zum nächsten Zeilenanfang zu gelangen.

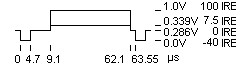

Das Videosignal selbst nutzt einen Spannungshub von 1Volt aus, man sagt auch, der Spitze-Spitze-Wert (Peak-Peak) beträgt 1V. Die absolute Spannung ist nicht festgelegt, es kann also von 0V-1V oder auch von 2V-3V reichen. Zur besseren Erklärung nehme ich den Fall 0V-1V, alle Videospannungen liegen also zwischen 0V und 1V. Das Videosignal, das sichtbare Bildinformation enthält, liegt zwischen 0.3V und 1.0V, 0.3V entspricht Schwarz und 1.0V entspricht Weiß. Diesen Bereich hat man in 100IRE eingeteilt, so daß 0.3V = 0IRE und 1.0V = 100IRE ist. 0V entspricht dann ca. -43IRE. Außerhalb der sichtbaren Bildinformation hat das Videosignal 0.3V, das ist der sog. Blank, also der unsichtbare Anteil. In dieses Blank werden nun die Synchronsignale eingesetzt. Die haben eine Spannung von 0V = -43IRE.

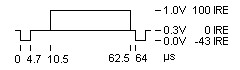

|

| Timing einer Zeile für 625/50-System nicht maßstabsgerecht |

Eine einzelne Zeile hat jetzt folgenden Aufbau: von 0µs bis 4.7µs: Sync = 0V von 4.7µs bis 10.5µs: Blank = 0.3V back porch (hinter dem Sync) von 10.5µs bis 62.5µs: Video = 0.3-1.0V, je nach Bildinhalt von 62.5µs bis 64.0µs: Blank = 0.3V front porch (vor dem Sync) danach beginnt die nächste Zeile mit dem Sync.

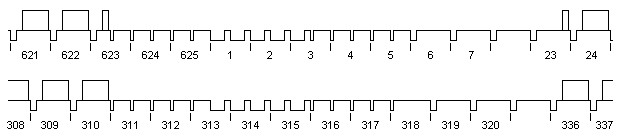

|

| Vertikalsync 625/50-System Gezeigt ist jeweils der Ausschnitt bei einem Halbbildwechsel – nicht maßstabsgerecht obere Zeile: Ende vom even Field und Anfang vom odd Field untere Zeile: Ende vom odd Field und Anfang vom even Field |

Der Vertikalsync ist etwas komplizierter. Dazu werden die Syncsignale der ersten Zeilen eines jeden Halbbildes wesentlich länger gemacht. Allerdings soll auch die zeilenweise horizontale Synchronisation nicht gestört werden. Da der Anfang des even Fields aber in der Mitte von Zeile 313 liegt, werden die Zeilen am Anfang jedes Halbbildes in jeweils zwei kurze Zeilen mit je 32µs Länge aufgeteilt. Damit die Synchronelektronik eines Fernsehers möglichst einfach wird, (zuerst wurde ja alles mit Röhren gemacht, jedes bißchen Elektronik war richtig teuer) wird senderseitig viel aufbereitet. Zeile 623 bis 625 wird jeweils in halbe Zeilen von je 32µs aufgeteilt, der Sync ist jeweils nur 2.35µs breit. Zeile 1 bis 2 und die erste Hälfte von Zeile 3 besteht fast ganz nur aus einem Synchronsignal. Die zweite Hälfte von Zeile 3 und Zeile 4 bis 5 werden wieder in halbe Zeilen je 32µs aufgeteilt. Von Zeile 311 bis 317 wird es ganz ähnlich gemacht.

Im Fernseher wird erst einmal das gesamte Synchronsignal vom restlichen Videosignal getrennt (alles, was < 0.15V ist, ist Sync), das geschieht im sog. Amplitudensieb (so hieß das jedenfalls früher), man erhält dann den sog. Composite Sync oder CSYNC. Alle 64µs ist eine fallende Flanke des CSYNCs vorhanden, damit wird die Horizontalablenkung gesteuert. Wenn der CSYNC über einen Tiefpaß gefiltert wird, erhält man 50-mal pro Sec. einen Spannungspuls für die Vertikalsynchronisation. Durch die so komliziert erscheinende Aufteilung mit den halben Zeilen davor und dahinter (das sind die Vor- und Nachtrabanten) wird sichergestellt, das der zeitliche Abstand der Pulse genau 312.5 Zeilen beträgt. Ohne diesen Aufwand würde der Abstand in einem Halbbild etwas kürzer als im anderen sein und die Zeilen der beiden Halbbilder werden nicht genau ineinandergeschachtelt, sondern habe ungleiche Abstände.

Videosysteme 625/50 und 525/60

Bisher habe ich nur das 625/50-System beschrieben (das was oft als PAL bezeichnet wird, aber noch haben wir gar keine Farbe!). In USA hat das Stromnetz 60HZ, daher hat man andere Bild-und Zeilenfrequenzen: 30 Bilder/sec, 525 Zeilen, davon 483 Zeilen sichtbar (im analogen Format, bei 525/60 ist das etwas konfuser und nicht ganz einheitlich in diesem Punkt). Es wird ebenfalls mit Zeilensprung gearbeitet. Die Zeilenfrequenz beträgt 525 * 30Hz = 262.5 * 60Hz = 15.75KHz.

|

| Vertikalsync 525/60-System Gezeigt ist jeweils der Ausschnitt bei einem Halbbildwechsel – nicht maßstabsgerecht obere Zeile: Ende vom even Field und Anfang vom odd Field untere Zeile: Ende vom odd Field und Anfang vom even Field |

Seit der Digitaltechnik hat man die Frequenzen leicht geändert, damit man mit beiden Systemen mit der gleichen Abtastfrequenz arbeiten kann: Zeilenfrequenz 15.734KHz und Vertikalfrequenz 59.94Hz. Die Zeilen sind von 1 bis 525 durchnumeriert, Zeile 22 bis 263 (Zeile 263 nur die erste Hälfte) und 285 bis 525 (Zeile 285 nur die zweite Hälfte).

|

| Timing einer Zeile für 525/60-System nicht maßstabsgerecht |

Eine Zeile sieht fast genau so aus wie die des 625/50-Systems, nur ist sie 63.55µs lang statt 64µs. 0IRE entspricht 0.286V, 100IRE ist 1.0V. Der Syncpegel von 0.0 ist demnach bei -40IRE. Außerdem ist der Schwarzpegel nicht bei 0.286V (0IRE) sondern bei 0.339V = 7.5IRE.

Das ist der berüchtigte Setup, auf einem PAL-Fernseher ist das Schwarz bei einem NTSC-Signal dann zu hell und muß entsprechend korrigiert werden (wenn es nicht automatisch geschieht). Der Blank liegt aber immer noch bei 0.286V = 0IRE. Auch der Vertikalsync wird in ganz ähnlicher Weise durchgeführt wie bei 625/50, es stecken die gleichen Überlegungen dahinter.

Klemmung

Der absolute Spannungspegel eines Videosignals ist nicht definiert. Nun muß ein Fernseher aber mit genau definierten Pegeln arbeiten. Deshalb wird das Videosignal zu bestimmten Zeitpunkten auf einen definierten Pegel gezogen. Ein Fernseher, der einen Sender über seinen Tuner empfängt, nimmt dazu die Sync-Signale. Sobald ein Sync erkannt wird, wird die Syncspannung auf einen festen Pegel gezogen, das restliche Videosignal stimmt dann auch. Das ist sinnvoll bei einem Tuner (das hängt mit der Modulation im Sender zusammen, ist für DVD aber uninteressant), bei Videosignalen wie von DVD oder ganz besonders von Videorecordern kann die Höhe des Syncsignales von den idealen -43IRE abweichen. Deshalb wird als Referenz der Blank unmittelbar nach jedem Sync-Signal genommen (also der back porch) und dieser auf eine definierte Spannung gezogen. Jetzt hat man definierte Pegel für den Bereich 0IRE-100IRE bzw. 7.5IRE-100IRE für Schwarz bis Weiß.

Gammakorrektur

Kameras, Bildröhren und auch das Auge reagieren nicht-linear auf das Licht bzw. den Elektronenstrahl. Bei halbem maximalen Strom hat die Leuchtschicht nicht 50% der Helligkeit, sondern weniger. Auch das Auge reagiert ähnlich, für den halben Helligkeitseindruck braucht man weniger als halb so viel Licht. Man hat eine nicht-lineare Funktion zwischen Strahlstrom und Helligkeit festgelegt, die dem tatsächlichen Verhalten der Leuchtschicht nahe kommt, dabei ist

Y' = Strahlstrom / maximaler Strahlstrom Y = Helligkeit / Helligkeit bei max. Strahlstrom

dann gilt:

Y = Y' ** 2.2 oder Y = exp(2.2 * ln(Y'))

Auf Kameraseite wird genau das Umgekehrte gemacht. Alle Videosignale, egal ob analog oder digital, ob S/W oder Farbe, arbeiten mit den gammakorrigierten Werten Y‘ und den entsprecheden Signalen. Der Helligkeitseindruck des Auges entspricht grob etwa dem gammakorrigierten Y‘, nicht dem Y. Bei den folgenden Beschreibungen lasse ich aber der Einfachheit halber den Strich bei den Variablen weg, schreibe also nur noch Y, obwohl immer nur die gammakorrigierten Werte gemeint sind. Das dürfte auch nicht zu Verwechslungen führen, da es keine nicht-gammakorrigierten elektrischen Signale gibt, weder analog noch digital.

Farbfernsehen

Beim Farbfernsehen war die größte Schwierigkeit das Kompatibilitätsproblem. S/W-Fernsehen war schon eingeführt und Farbsendungen mußten ebenso in S/W empfangen werden können wie auch S/W-Sendungen mit einem Farbfernseher ansehbar sein mußten (vor allem die erste Forderung war der Knackpunkt). Hinzu kam noch, daß die Bandbreite der Fernsehsender bereits vollständig genutzt wurde. Wie also bekommt man da noch die Farbinformation hinein?

Farbensehen

Das sichtbare Licht belegt einen relativ schmalen Abschnitt im Spektrum der elektromagnetischen Wellen bei einem Wellenlängenbereich von ca. 440nm bis 880nm (1nm = 0.000001mm). Eine verteilte Strahlung, in der alle Anteile gleich stark vertreten sind, ergibt weißes Licht. Ungleichmäßige Verteilungen der Strahlung in Abhängigkeit der Wellenlänge ergibt farbiges Licht, wenn kein Licht da ist, hat man Schwarz. Damit gibt es nicht nur praktisch unendlich viele Farben, sondern man benötigt auch unendlich viele Parameter, um sie festzulegen (für jede Wellenlänge ein Intensitätswert).

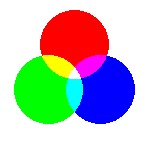

Nun ergeben für das Auge viele Kombinationen exakt die gleiche Farbe, z.B. gibt es ein reines Gelb (nur die „gelbe“ Wellenlänge vorhanden), ebenso kann man genau das gleiche Gelb mit je einem Grün und einem Rot zusammen erreichen. Das Auge hat nämlich nur drei verschiedenartige Rezeptoren in der Netzhaut, die jeweils bevorzugt auf Rot, Grün und Blau ansprechen. Deshalb kann man nahezu jede Farbe durch Überlagerung von entsprechend dosierten jeweils rotem, grünem und blauem Licht erzeugen.

Dabei handelt es sich um die additive Farbmischung (mehrere Lichtquellen kommen zusammen), etwas anderes ist die subtraktive Farbmischung beim Mischen von Malerfarben. Hier wird jeweils das Absorbtionsvermögen der Farben kombiniert.

|

| Additive Farbmischung |

Beim (additiven) Mischen der drei Grundfarben ergeben sich folgende Kombinationen (gilt für bereits gammakorrigierte Signale):

| Grün | Rot | Blau | Mischfarbe | Helligkeit |

|---|---|---|---|---|

| 0% | 0% | 0% | Schwarz | 0% |

| 0% | 0% | 100% | Blau | 11% |

| 0% | 100% | 0% | Rot | 30% |

| 0% | 100% | 100% | Purpur | 41% |

| 100% | 0% | 0% | Grün | 59% |

| 100% | 0% | 100% | Cyan | 70% |

| 100% | 100% | 0% | Gelb | 89% |

| 100% | 100% | 100% | Weiß | 100% |

Die letzte Spalte Helligkeit ergibt sich aus der unterschiedlichen Empfindlichkeit des Auges für die drei Grundfarben. Grün liefert 59% des Helligkeitseindrucks, Rot 30% und Blau 11%. Andere Farben werden entsprechend erzeugt, denn jede Grundfarbe kann jeden Wert zwischen 0% und 100% annehmen. Dies ist das RGB-Farbmodell.

Farbräume

Technisch wird dieses RGB Farbmodell für die Fernsehtechnik verwendet. Kameras habe z.B. drei S/W-Sensoren (zumindest die professionellen), auf die jeweils das entsprechend eingefärbte Bild gelangt. Röhrenprojektoren haben drei S/W-Bildröhren mit passenden Farbfiltern und Objektiven davor, deren Bilder werden genau übereinander projeziert. Man kann ohne weiteres die R-, G- und B-Ausgänge der Kamera mit den RGB-Eingängen des Projektors verbinden und erhält eine Farbbildübertragung in hervorragender Qualität. Leider braucht man dazu auch drei S/W-Videokanäle für die Übertragung, außerdem kann ein S/W-Fernseher mit keinem Teilsignal vernünftige Bilder erzeugen.

Deshalb braucht man zunächst einmal ein S/W-Signal. Dieses erhält man aus 29.9% Rot, 58.7% Grün und 11.4% Blau und wird Y-Signal genannt: Y = 0.299 * R + 0.587 * G + 0.114 * B

Von den R-, G- und B-Signalen zieht man jetzt die Helligkeit ab und erhält die sog. Farbdifferenzsignale:

B - Y R - Y G - Y

Man braucht nur zwei dieser drei Farbdifferenzsignale, das dritte kann daraus errechnet werden:

0.114 * (B-Y) + 0.299 * (R-Y) + 0.587 * (G-Y) = 0

da

(0.114 * B + 0.299 * R + 0.587 * G) - (0.114 * Y + 0.299 * Y + 0.587 * Y) = Y - Y = 0

Da G – Y am kleinsten ist läßt man das weg und behält B-Y und R-Y.

Also:

Y = 0.299 * R + 0.587 * G + 0.114 * B B-Y = -0.299 * R - 0.587 * G + 0.886 * B R-Y = 0.701 * R - 0.587 * G - 0.114 * B

Obige Beziehung stellt mathematisch eine Matrixmultiplikation dar, die quadratische Anordnung der neun Zahlen wie in obigen Formeln, aber ohne +, –, * und die Variablen ist dann die Matrix. Im Farbdecoder eines Fernsehers wird die umgekehrte Operation durchgeführt, mathematisch ist das ebenfalls eine Matrixmultiplikation, dort wird der Schaltungsteil, der das durchführt, Farbmatrix oder kurz Matrix genannt.

B-Y und R-Y werden mit konstanten Faktoren skaliert, je nach Skalierungsfaktoren haben sie dann unterschiedliche Bezeichnungen:

U = 0.492 * (B-Y) V = 0.877 * (R-Y)

Die Faktoren sind so gewählt, daß bei Gelb und Cyan mit je 75% Helligkeit ein moduliertes PAL-Signal nicht über 100% Weiß hinausgeht. U und V werden für die Farbmodulation nach PAL und NTSC verwendet.

Pb = 0.564 * (B-Y) Pr = 0.713 * (R-Y)

Die Faktoren sind so gewählt, daß Pb und Pr jeweils im Bereich -0.5…+0.5 liegen. Diese Skalierung wird für das SMPTE Komponentenvideo verwendet und finden sich an einigen Projektoren und Playern als Anschlußbuchsen. Dort werden sie meistens wieder als Y,U,V bezeichnet, was aber nicht ganz korrekt ist. Leider kocht Sony mit den Betacam-Komponentenvideo sein eigenes Süppchen, während bei RGB und bei SMPTE Y, Pb, Pr kein Setup verwendet wird, ist das bei Betacam der Fall, allerdings nur beim Y-Signal! R-Y und B-Y sind jeweils um den Faktor 1.333 größer als Pb und Pr. Auf dieses Betacamformat gehe ich nicht weiter ein, da ich den Daten dazu nicht ganz traue, sie liegen mir nur in ziemlich ungenauer Form vor. Wenn man also ein Gerät mit Betacam-YUV vor sich hat, wird es zusammen mit SMPTE-Geräten zu falscher Helligkeit und falscher Farbsättigung führen.

Bei elektrischen Komponentensignalen bedeutet ein Wert von 1.0 eine Spannung von 0.7Volt. Bei RGB liegt jedes Signal zwischen 0.0V und 0.7V (eventuell vorhandene Syncs gehen extra, die wären dann bei -0.3V). Bei Y,Pb,Pr (oft als YUV bezeichnet) liegt Y zwischen 0.0V und 0.7V, Pb und Pr jeweils zwischen -0.35V und +0.35V. Sony Betacam hat abweichend davon für Y einen Bereich von 0.0V bis 0.714V (inclusive Setup).

Jetzt hat man also wieder drei Komponenten, aber eines davon ist das normale S/W-Signal. Es hat sich gezeigt, daß das Auge bei der Schärfe bei U und V bzw. Pb und Pr wesentlich weniger anspruchsvoll ist als bei der Y-Komponente. Man kann also die Bandbreite der Farbdifferenzsignale verkleinern, ohne daß dabei die Bildqualität leidet. Genau das wird bei der PAL- und NTSC-Modulation ausgenutzt.

Für die 8 Kombinationen aus den 3 Grundfarben ergibt sich für alle Signale folgende Tabelle:

| Farbe | G | R | B | Y | B-Y | R-Y | U | V | Pb | Pr |

|---|---|---|---|---|---|---|---|---|---|---|

| Weiß | 1.000 | 1.000 | 1.000 | 1.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 |

| Gelb | 1.000 | 1.000 | 0.000 | 0.886 | -0.886 | 0.114 | -0.436 | 0.100 | -0.500 | 0.081 |

| Cyan | 1.000 | 0.000 | 1.000 | 0.701 | 0.299 | -0.701 | 0.147 | -0.615 | 0.169 | -0.500 |

| Grün | 1.000 | 0.000 | 0.000 | 0.587 | -0.587 | -0.587 | -0.289 | -0.515 | -0.331 | -0.419 |

| Purpur | 0.000 | 1.000 | 1.000 | 0.413 | 0.587 | 0.587 | 0.289 | 0.515 | 0.331 | 0.419 |

| Rot | 0.000 | 1.000 | 0.000 | 0.299 | -0.299 | 0.701 | -0.147 | 0.615 | -0.169 | 0.500 |

| Blau | 0.000 | 0.000 | 1.000 | 0.114 | 0.886 | -0.144 | 0.436 | -0.100 | 0.500 | -0.081 |

| Schwarz | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 | 0.000 |

Farbmodulation (PAL/NTSC/SECAM)

Bisher ist noch offen, wie in einem S/W-Signal die Farbinformation untergebracht werden kann, ohne mehr Bandbreite zu beanspruchen. Wenn man sich das Spektrum des Videosignals ansieht, kann man feststellen, daß nicht alle Frequenzen durchgängig vorhanden sind. Es sind vielmehr viele Lücken vorhanden, da bei einem Standbild nur Vielfache von 25Hz vorhanden sind. Auch bei bewegten Bildern ist in den Lücken nur sehr wenig Information vorhanden, die wesentlichsten Anteile sind immer noch die Vielfachen von 25Hz. Daher moduliert man die Farbinformation so, daß dessen Spektrum genau in diese Lücken fällt. Bei PAL und NTSC wird die sog. Quadraturmodulation verwendet. Es werden zwei Trägerfrequenzen mit exakt gleicher Frequenz jedoch 90° Phasenverschiebung erzeugt:

sin(2*PI*f*t) f = Trägerfrequenz, t = Zeit

und

cos(2*PI*f*t)

Das Chromasignal, das die Farbinformation enthält, setzt sich dann wie folgt zusammen:

chroma = U * sin(2*PI*f*t) + V * cos(2*PI*f*t)

Die Frequenz f wird so gewählt, daß das Spektrum des Chroma-Signales genau in die Lücken des S/W-Videosignals fällt. Außerdem wird die Frequenz f so hoch wie möglich gewählt, ohne jedoch die oberen Seitenbänder zu stark zu beschneiden (eine modulierte Frequenz enthält Spektralanteile, deren Frequenzen jeweils der Summe und Differenz von f und dem Nutzsignal U bzw. V entspricht).

Bei PAL wird das U und V genommen, wie es im Kapitel „Farbräume“ beschrieben ist, bei NTSC sind das stattdessen die Signale I und Q, wobei

I = V * cos30° - U * sin30°

und

Q = V * sin30° + U * cos30°

ist. Dies hatte man gemacht, nachdem festgestellt wurde, daß das Auge für eines dieser beiden Signale noch weniger Bandbreite benötigte als für das andere. Es wird aber praktisch nicht genutzt und deshalb nimmt man beim (später hinzugekommenen PAL) direkt die Signale U und V.

Dieses Chromasignal hat jetzt eine bestimmte Amplitude und Phase:

Chroma = S * sin(2*PI*f*t+C)

wobei

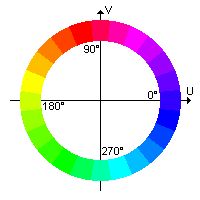

S = sqrt(U * U + V * V) C = atan2(V, U)

|

| Farbkreis |

S ist die Farbsättigung, wenn S = 0 ist, dann ist auch U und V jeweils 0 und damit R = G = B, was bedeutet, daß man einen Grauwert ohne Farbe vor sich hat. C ist der Farbton und liegt im Bereich 0…2*PI, was einem Winkel von 0°…360° entspricht. Jedem Winkel entspricht ein bestimmter Farbton:

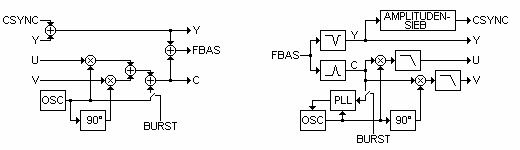

|

| links: Farbträgermodulation rechts: Farbträgerdemodulation |

Auf der Decoderseite wird das Chromasignal jeweils mit sin(2*PI*f*t) und mit cos(2*PI*f*t) multipliziert und anschließend tiefpaßgefiltert, dabei erhält man dann wieder U und V bzw. I und Q. Dazu benötigt man aber die Trägerfrequenz in der richtigen Phase, um daraus den sin und cos zu erzeugen. Zu diesem Zweck wird in der Austastlücke kurz nach dem Sync in jeder Zeile (in dem Back Porch) ein kurzes Trägersignal eingesetzt, bei NTSC sind das z.B. ca. 10 Perioden von -sin(2*PI*f*t). Das ist der Burst. Der Decoder hat intern einen Oszillator für die Trägerfrequenz, der mit jedem Burst nachsynchronisiert wird.

Da das Farbsignal wegen der kleineren Bandbreite eine größere Laufzeit als das Y-Signal hat, wird sowohl im Encoder als auch im Decoder das Y-Signal durch eine Verzögerungsleitung geschleift (in den Bildern nicht eingezeichnet).

Bei einem S-Video-Signal bleibt Y und Chroma getrennt: Y ist das S/W-Signal mit CSYNC, Chroma der modulierte Farbträger mit dem Burst. Da die Trennung von Y und C beim Farbdecoder nicht 100%-ig möglich ist, können Helligkeitssignale, die Frequenzen in der Nähe des Farbhilfsträgers haben (z.B. kleinkarierte Muster), falsche Farben entstehen lassen. Das ist die berüchtigte Cross-Color Störung, die bei einer Y/C-Verbindung vermieden wird. Außerdem wird die Bandbreite des Helligkeitssignales bei einem FBAS-Farbdecoder durch das Filter beschnitten, so daß die horizontale Auflösung geringer wird.

Bei SECAM ist man einen anderen Weg gegangen. Um Farbverfälschungen durch Phasenfehler zu vermeiden (siehe Kapitel „PAL“ und „NTSC“), werden U und V abwechselnd in jeder Zeile allein übertragen, außerdem verwendet man dann die Frequenzmodulation (nicht die Amplitude, sondern die Frequenz des Farbhilfsträgers wird verändert). Es wird also in einer Zeile nur U übertragen, in der nächsten dann V. Es gibt ebenfalls einen Burst, der jeweils eine Referenzfrequenz vorgibt, auf diese Weise kann der Farbdecoder die U- von den V-Zeilen unterscheiden. Außerdem muß er das jeweils fehlende Signal von der vorhergehenden Zeile nehmen. Da dieses Format für DVD kaum eine Rolle spielt (selbst in Frankreich geben die Player anscheinend PAL aus), gehe ich nicht weiter auf SECAM ein.

PAL

Ein großer Nachteil bei NTSC ist die Farbverfälschung, die sich sofort stark sichtbar bemerkbar macht, sobald Phasenfehler in der Übertragungsstrecke auftreten. Auf dem Farbkreis entspricht ja einem anderen Winkel ja gleich ein anderer Farbton. Bei PAL wird daher in jeder 2. Zeile das Vorzeichen von V umgedreht, im Decoder ebenfalls. Ein Phasenfehler von z.B. +5° in einer Zeile wird dadurch zu einem Phasenfehler von -5° in der anderen. Bei Mittelwertbildung von U und V mit dem Werten der vorhergehenden Zeile heben sich diese Phasenfehler auf, solange aufeinanderfolgende Zeilen möglichst ähnlichen Inhalt von U und V enthalten, das ist aber meistens der Fall. Lediglich die Sättigung nimmt um cos(2.5°) ab, also um ca. 0.1%. Selbst bei Phasenfehlern von 20° nimmt die Sättigung nur um ca. 1.5% ab, das ist praktisch unsichtbar. Durch die Mittelwertbildung mit der vorhergehenden Zeile sinkt die vertikale Auflösung des Farbsignals auf die Hälfte. Wenn keine Phasenfehler vorhanden sind (z.B. bei einer kurzen Verbindung vom DVD-Player zum Fernseher, FBAS oder S-Video) ist es von Vorteil, wenn man beim Farbdecoder des Fernsehers diese Phasenkorrektur abschalten kann (bei einigen Videorecordern gibt es einen „Edit-Schalter“, mit dem man das machen kann, dann werden die Kopien vom Camcorder besser).

Die Videobandbreite beträgt beim originalen PAL-Fernsehformat (also inclusive der HF-Übertragungsstrecke vom Sender bis zum Empfänger) 5MHz. Für den Farbhilfsträger hat man eine Frequenz von 4.43361875MHz gewählt, so verschachteln sich die Spektren des S/W- und des Chroma-Signals ineinander. Der Burst hat eine Phase von 135°:

Burst = 15.2IRE * (-sin(2*PI*f) + cos(2*PI*f))

für die Zeilen, wo das Vorzeichen von V nicht umgedreht ist und

Burst = 15.2IRE * (-sin(2*PI*f) - cos(2*PI*f)) entspricht 225°

für die Zeilen, wo das Vorzeichen von V umgedreht ist. Das ergibt eine Gesamtamplitude von 21.5IRE.

Der Burst hat eine Dauer von ca. 2.3µs und beginnt ca. 5.3µs nach dem Beginn des H-Syncs.

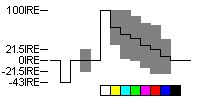

So regelt der Decoder die Referenzfrequenz (wegen der Trägheit der Regelung) auf 180° und kann anhand der Phasensprünge des Bursts entscheiden, in welchen Zeilen das Vorzeichen von V umgedreht ist. Die Amplitude des Bursts wird als Referenzamplitude für die Farbdecodierung genommen, so daß die Farbsättigung konstant bleibt, auch wenn z.B. im Videosignal Frequenzen >3MHZ schon abgeschwächt werden (z.B. nicht exakt eingestellte Sender im Fernseher). Eine Zeile mit einem Farbbalkentestbild (von links nach rechts Weiß, Gelb, Cyan, Grün, Purpur, Rot, Blau, Schwarz, alle Zeilen gleicher Bildinhalt) hat dann folgendes Aussehen:

|

| PAL-Testzeile 100% Weiß, alle anderen Farben 75%Helligkeit, 100% Sättigung |

Für das Farbbalkentestbild nimmt man normalerweise eines, bei dem die Farben außer Weiß nur 75% Helligkeit haben, also z.B. Gelb = 0.75 * R + 0.75 * G + 0.0 * B. Wie man sieht, reicht das Farbsignal bei Gelb und Cyan genau bis zum Weißpegel, das ist kein Zufall, sondern die Faktoren für U und V (siehe Kapitel Farbräume) sind extra so gewählt worden. So wird ein Fernsehsender nicht übersteuert, solange 100% gesättigte Farben unter 75% Helligkeit bleiben. Eine leichte Übersteuerung bei helleren Farben (z.B. 100% Gelb) wird in Kauf genommen, da das nur selten vorkommt und noch keine gravierenden Fehler produziert. Bei Videorecordern und DVD-Playern ist kein Sender vorhanden, der übersteuert werden kann (wenn man nicht gerade die Antennenverbindung nimmt).

NTSC

Bei NTSC wird die Grundidee mit der Quadraturmodulation direkt übernommen. Deshalb wurde die Abkürzung NTSC oft als „Never The Same Color“ interpretiert, da bei jedem Phasenfehler sofort Farbverfälschungen sichbar werden. Zum Ausgleich der Phasenfehler haben NTSC-Fernseher einen weiteren Bedienungsknopf, der mit Tint oder Hue beschriftet ist. Heute ist die Elektronik besser (zeitstabiler) geworden, so daß solche Farbverfälschungen seltener geworden sind.

Die Videobandbreite beträgt beim originalen NTSC-Fernsehformat (also inclusive der HF-Übertragungsstrecke vom Sender bis zum Empfänger) ca. 4MHz. Für den Farbhilfsträger hat man eine Frequenz von 3.579545MHz gewählt, so verschachteln sich die Spektren des S/W- und des Chroma-Signals ineinander. Wie schon im Kapitel „Farbmodulation“ erwähnt, wird nicht U und V genommen, sondern I und Q. Der Burst hat eine Phase von 180°:

Burst = -20IRE * sin(2*PI*f)

Der Burst hat eine Dauer von ca. 2.5µs und beginnt ca. 5.2µs nach dem Beginn des H-Syncs.

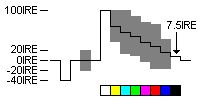

So regelt der Decoder die Referenzfrequenz auf 180°. Die Amplitude des Bursts wird als Referenzamplitude für die Farbdecodierung genommen, so daß die Farbsättigung konstant bleibt, auch wenn z.B. im Videosignal Frequenzen > 3MHZ schon abgeschwächt werden (z.B. nicht exakt eingestellte Sender im Fernseher). Eine Zeile mit einem Farbbalkentestbild (von links nach rechts Weiß, Gelb, Cyan, Grün, Purpur, Rot, Blau, Schwarz, alle Zeilen gleicher Bildinhalt) hat dann folgendes Aussehen:

|

| NTSC-Testzeile 100% Weiß, alle anderen Farben 75%Helligkeit, 100% Sättigung |

Für das Farbbalkentestbild nimmt man normalerweise eines, bei dem die Farben außer Weiß nur 75% Helligkeit haben, also z.B. Gelb = 0.75 * R + 0.75 * G + 0.0 * B. Wie man sieht, reicht das Farbsignal bei Gelb und Cyan genau bis zum Weißpegel, das ist kein Zufall, sondern die Faktoren für U und V (siehe Kapitel Farbräume), aus denen I und Q abgeleitet werden, sind extra so gewählt worden. Es sind die gleichen Faktoren für U und V wie bei PAL. So wird ein Fernsehsender nicht übersteuert, solange 100% gesättigte Farben unter 75% Helligkeit bleiben. Eine leichte Übersteuerung bei helleren Farben (z.B. 100% Gelb) wird in Kauf genommen, da das nur selten vorkommt und noch keine gravierenden Fehler produziert. Bei Videorecordern und DVD-Playern ist kein Sender vorhanden, der übersteuert werden kann (wenn man nicht gerade die Antennenverbindung nimmt).

Farbdisplays

Hier werden die gängigen Farbdisplays beschrieben, die auch im Heimkino Verwendung finden. Es gibt noch einige weitere Methoden, die aber nicht (mehr) benutzt werden, z.B. das Eidophor-Projektionsverfahren, das extrem aufwendig und empfindlich war und selbst im Profibereich nach Einführung von DLP kaum noch Bedeutung hat. Alle Projektionstechniken können für eine Projektion auf eine Leinwand oder zur Rückprojektion verwendet werden. Bei einer Rückprojektion bilden Projektor und Leinwand eine geschlossene Einheit, über Spiegel wird das Bild von innen auf die Leinwand projeziert. Vorteil: keine Justage am Aufstellungsort, Nachteil: sehr klobige Kästen.

Farbfernseher

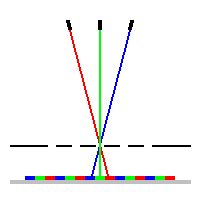

|

| Strahlengang in Farbbildröhre |

Dies ist immer noch die am meisten verbreitete Technik. Kernstück eines jeden Fernsehers und VGA-Monitors ist die Farbbildröhre. Sie hat nicht nur eine Kathode als Elektronenstrahlquelle, sondern gleich drei, für jede Grundfarbe eine. Auf der Innenseite der Front befinden sich Millionen kleiner Leuchtstoffpunkte in den Grundfarben Rot, Grün und Blau. Damit nun jeder Elektronenstrahl nur die Leuchtpunkte „seiner“ Farbe trifft, befindet sich vor der Leuchtschicht (aus Richtung der Elektronenstrahlen gesehen) eine Lochmaske. Das Bild zeigt die Funktion der Lochmaske bei einer Inline-Röhre, da sind die Kathoden nebeneinander angeordnet, bei VGA-Monitoren sind die Kathoden meistens in Form eines gleichseitigen Dreiecks angeordnet, um mehr Leuchtpunkte pro Fläche für die hohen SVGA-Auflösungen unterbringen zu können. Der Vorteil der Inlinetechnik ist die wesentlich einfachere Konvergenzeinstellung, d.h. die Elektronenstrahlen müssen sich überall auf dem Schirm treffen, so daß die drei Teilbilder in den Grundfarben sich decken. Die Zahl der Löcher in der Lochmaske ist identisch mit der Zahl der Leuchtpunkte je einer Grundfarbe und deutlich höher als die Zahl der Bildpunkte, die auf dem Schirm dargestellt werden. Ein Farbfernseher und ein VGA-Monitor hat demnach kein Pixelraster, auf das ein Bild skaliert werden muß.

Bei Anwesenheit von externen Magnetfeldern werden die Elektronenstrahlen auch hinter der Lochmaske noch zusätzlich abgelenkt, so daß sie auch die „falschen“ Farben treffen. Das sind die bekannten Farbflecken, die man sieht, wenn z.B. der nicht magnetisch abgeschirmte Sub zu nahe am Fernseher steht.

Plasmadisplays

Plasmaschirme sind flach und können wie Bilder an die Wand gehängt werden. Basis dieser sehr teuren Technik ist die Glimmlampe: in einem kleinen Glaskolben befindet sich neben den zwei Elektroden ein Gas unter sehr niedrigem Druck. Beim Anlegen einer elektrischen Spannung fließt ab der sog. Zündspannung ein Strom, der die Gasatome zum Leuchten anregt. Die Glimmlampe sendet UV-Licht aus, das dann auf einen Leuchtstoff trifft, genau so wie bei den normalen Leuchtstofflampen, die allerdings weißen Leuchtstoff verwenden. Es gibt drei verschiedene Leuchtstoffe für Rot, Grün und Blau. Ein Plasmaschirm ist eine riesige Ansammlung von winzigen Glimmlampen für die Farben Rot, Grün und Blau. Der Schirm ist wie die normale Bildröhre selbstleuchtend und erreicht wie diese eine sehr gute Farbwiedergabe (die Grundfarben lassen sich bei entsprechender Rezeptur der Leuchtstoffe gut realisieren) und nahezu unabhängig vom Betrachtungswinkel. Der Aufwand ist allerdings enorm. Ein Bildschirm mit z.B. 720*576 Pixeln enthält 1244160 einzelne winzige Glimmlampen. Die Ansteuerung erfolgt aber nicht mit entsprechend vielen Leitungen, sondern matrixförmig, es wird jeweils eine Zeile und Spalte angesprochen. Da die Zündspannung höher als die Spannung ist, die eine bereits leuchtende Glimmlampe benötigt (>Löschspannung), wird an alle Glimmlampen eine Spannung zwischen Lösch- und Zündspannung gelegt. Wird in einem Kreuzungspunkt die Spannung über die Zündspannung erhöht, geht genau diese eine Glimmlampe an, wird die Spannung stattdessen unter die Löschspannung erniedrigt, geht sie aus. Alle anderen Glimmlampen bleiben dabei so, wie sie sind.

Nachteil bei Plasmadisplays ist das fest vorgegebene Pixelraster, bei abweichenden Formaten muß skaliert werden.

LCD

LCD steht für Liquid Cristal Display. Bestimmte Stoffe drehen die Polarisationsebene des Lichtes bei Anlegen einer elektrischen Spannung. Befindet sich dieser Stoff zwischen zwei Polarisationsfiltern, kann man die Lichtdurchlässigkeit mit der elektrischen Spannung steuern. LCD-Displays bestehen aus mehreren Schichten: Polarisationsfilter, durchsichtige Elektrode (sehr dünne Metallschicht, aufgedampft), Flüssigkristall, durchsichtige Elektrode, Polarisationsfilter. Die Form der Elektroden bestimmt die Form der darstellbaren Symbole. Für Graphikdisplays nimmt man quadratische Pixel als Symbolform. Für farbige Displays besteht jedes Pixel aus drei Symbolen, hinzu kommt noch eine farbige Maske, so daß jedes Pixel aus drei gefärbten Symbolen besteht. Im allgemeinen wird die Ansteuerelektronik mit in die Displays integriert. Die Herstellung ist relativ teuer, da die Ausschußrate ziemlich hoch ist. Trotzdem wird dem Kunden noch eine gewisse Zahl von defekten Pixeln (die entweder nicht an- oder ausgehen) zugemutet. LCD-Bildschirme haben auf der Rückseite eine flächige Beleuchtung. Nachteil von LCD-Boldschirmen ist die Abhängigkeit vom Betrachtungswinkel und der schlechte Schwarzwert, die Pixel können nicht ganz „dicht“ machen. LCD-Projektoren sind im Prinzip wie Diaprojektoren aufgebaut, statt des Dias befindet sich ein LCD-Panel im Lichtweg. Die Winkelabhängigkeit spielt hier keine Rolle, da der Lichtweg durch das LCD-Panel im Projektor fest vorgegeben ist. Bessere Projektoren haben drei S/W-LCD-Panels, für jede Grundfarbe eines, mit jeweiligen Farbfilter und fügen die Strahlengänge mit Prismen vor dem Objektiv zusammen.

Nachteil bei LCD ist das fest vorgegebene Pixelraster, bei abweichenden Formaten muß skaliert werden.

DLP

DLP ist eine relativ neue Projektionstechnik. Auf einem großen Chip sind so viele winzige Spiegel untergebracht, wie Pixel im Bild vorhanden sind. Diese Spiegel können unabhängig voneinander angesteuert werden und jeweils zwischen zwei Stellungen hin und herkippen. In einer Stellung reflektiert der Spiegel das Licht ins Objektiv, in der anderen Stellung nicht. Durch unterschiedlich langes Kippen in die „An-„Stellung lassen sich auch Grauwerte realisieren. Für die Farbwiedergabe nimmt man entweder drei DLP-Chips (sehr teure Lösung, aber die beste) oder man zeigt die drei Grundfarben nacheinander. Zu diesem Zweck befindet sich ein Farbrad im Strahlengang, auf dem drei Farbsektoren in Rot, Grün und Blau sind. Der Schwarzwert ist wesentlich besser als bei LCD, hängt sicher auch von konstruktiven Details ab, wie gut der von Objektiv wegreflektierte Lichtstrahl verschluckt wird.

Nachteil bei DLP ist wieder das fest vorgegebene Pixelraster, bei abweichenden Formaten muß skaliert werden.

Röhrenprojektor

Das Prinzip ist einfach: Das Bild einer Bildröhre wird mit einem Objektiv auf eine Leinwand projeziert. Es werden normalerweise drei S/W-Bildröhren mit jeweils eigenem Farbfilter und Objektiv verwendet. Alle Vorteile eines VGA-Monitors hat man auch hier: kein vorgegebenes Pixelraster, innerhalb gewisser Grenzen frei wählbare Ablenkfrequenzen, sehr guter Schwarzwert. Dafür ist die Lichtstärke beschränkt, das Licht kommt ja nicht von einer Lampe, sondern direkt von der Leuchtschicht der Bildröhre. Man benötigt deshalb einen abgedunkelten Raum, was aber fürs Heimkino wohl sowieso angestrebt wird. Röhrenprojektoren sind sehr teuer (zum Glück gibt es ganz vernünftige Angebote von Gebrauchtgeräten), groß und schwer. Die Einstellung von Bildgeometrie und besonders der Konvergenz ist mühselig (wird bei einigen Modellen schon automatisiert) und der Standort liegt dann fest. Ein Standortwechsel erfordert eine komplette Neueinstellung. Für DVD-Wiedergabe gibt es aber bisher noch nichts besseres.

Laserprojektor

Diese Technik hat gerade eben den Laborstatus hinter sich gelassen. Fertige Geräte dürften wohl bald zu extrem hohen Preisen auf den Markt kommen. Drei Laser je Rot, Grün und Blau werden zusammengefaßt und dann gemeinsam mit Spiegelsystemen abgelenkt. Da Laser nur je eine Wellenlänge abstrahlen und somit echte 100% gesättigte Farben liefern, ist das Farbspektrum eines Laserprojektors größer als bei allen andern Farbdisplays. Die Tiefenschärfe ist nahezu unendlich: ohne Objektiv ist das Bild in jeder Entfernung automatisch scharf, auch wenn schräg projeziert wird. Technische Probleme machen vor allem die Laser (besonders der blaue) in entsprechender Stärke und die Ablenkeinheit. Spiegelräder und schwingende Kippspiegel sind nicht garade ideal. Man macht bereits Experimente mit integrierten Spiegeln auf einem Chip (ganz ähnlich wie DLP), wo sehr viele kleine Spiegelchen (wegen der Massenträgheit) alle im Gleichschritt bewegt werden, wodurch die gleiche Wirkung wie mit einem einzigen großen bewegten Spiegel erreicht wird. Auch hier hat man prinzipiell kein festes Pixelraster.

Die Lasereinheit kann getrennt von der Ablenkeinheit aufgestellt werden, die Verbindung erfolgt dann über Lichtleiter.

Messwerte

Es gibt zahlreiche Meßmöglichkeiten für ein Videosignal. Ich will nur auf die wichtigsten eingehen, die auch unmittelbaren Einfluß auf die sichtbare Bildqualität haben. Das ist zwar auch beim Videofrequenzgang der Fall, aber der geht teilweise in Form der Bandbreite (das ist die höchste Frequenz, die gerade um 3dB abgeschwächt wird) in die Auflösung mit ein.

Auflösung MHz

Die Bildschärfe wird vertikal durch die Zahl der Zeilen und horizontal durch die Bandbreite des Videosignales (in MHz) bestimmt. Nun möchte man aber ein einheitliches Auflösungsmaß sowohl vertikal und horizontal haben. Die vertikale Auflösung in Linien entspricht immer noch der Zeilenzahl. Für die horizontale Auflösung gilt z.B. für 5MHz: 52µs einer Zeile sind sichtbar. In jeder µs sind 5 Perioden der 5MHz enthalten, jede Periode kann je eine helle und dunkle Linie darstellen. Also können in jeder µs 10 Linien und in der ganzen Zeile 520 Linien dargestellt werden. Nun ist das Bild 1.33-mal so breit wie hoch. Daher muß man die 520 Linien durch 1.33 teilen und kommt so auf eine horizontale Auflösung von 390 Linien. Im Prinzip wählt man den größtmöglichen quadratischen Ausschnitt und zählt vertikal und horizontal die maximale Zahl der darstellbaren Linien. Bei einer Bandbreite B (in MHz) ergibt sich folgende horizontale Auflösung in Linien Z:

Z = B * 52 * 2 * 3 / 4 = B * 78

für 16:9 Fernseher würde gelten:

Z = B * 52 * 2 * 9 / 16 = B * 58.5

Allerdings nimmt man da meistens trotzdem auch das Maß, das für 4:3 Bildschirme gilt. Bei digital Video sind 53.3µs sichtbar, da würde Z = B * 80 gelten. Soweit ich bisher gesehen habe, wird aber normalerweise der Faktor 78 weiterhin benutzt. Bei DVD mit 720*576 Pixeln (625/50) hat man horizontal 540 Linien (720 * 3 / 4) und vertikal 576 Linien Auflösung, bei 525/60 entsprechend 540 und 480 Linien (jeweils für 4:3)

Bei normaler interlaced Darstellung (mit Zeilensprung) ist die sichtbare vertikale Auflösung wesentlich niedriger, nur ca. 60..70% der 576 Zeilen, näheres bei „digital Video“ im Kapitel progressive Scan

Rauschen

Es wird unterschieden zwischen dem Rauschen des Y-Signales und des Chroma-Signales (oder stattdessen U und V gemeinsam). Das Rauschen des Y-Signales ist das Helligkeitsrauschen und wird oft auch als Schnee bezeichnet, das Rauschen des Chroma-Signales ist das Farbrauschen und wird oft Konfetti genannt. Die Bezeichnungen schildern schon recht gut die Erscheinungsform des jeweiligen Rauschen. Helligkeitsrauschen sieht etwa wie grobkörniges Filmmaterial aus, Farbrauschen erzeugt hauptsächlich rote und blaue Flecken oder Streifen, vor allem auf dunklen Flächen sichtbar.

Als Meßwert wird das Verhältnis der Rauschleistung im Verhältnis zur max. Leistung des Nutzsignales genommen und als dB-Wert ausgedrückt. Die Leistung wird über die Effektivwerte der Spannungen ermittelt (Unutz und Urausch), damit ergibt sich:

Rauschabstand = 20 * log(Unutz / Urausch)

Der Effektivwert einer Spannung ist die Gleichspannung, die man anlegen müßte, um am gleichen Widerstand die gleiche mittlere Leistung zu liefern. Bei einem SIN-Signal ist der Effektivwert 0.707-mal der Spannung des Wellentales oder Wellenberges relativ zur Null-Linie. Näheres dazu in den Abschnitten Audio und digital Video.

Rauschabstände von 50dB sind für Videosignale schon als sehr gut zu bezeichnen, mehr ist bei einer 8-Bit Darstellung der Komponentensignale wie bei DVD auch nicht möglich. Unter ca. 40dB kann man das Videosignal als schlecht bezeichnen, dazwischen liegen dann die Qualitäten Ausreichend bis Gut.

Zusatzsignale

In der vertikalen Austastlücke (das sind die nicht sichtbaren Zeilen, die nicht in halbe Zeilen für den Vertikalsync aufgeteilt sind) sind diverse Zusatzsignale untergebracht. Vom Fernsehen her am bekanntesten dürfte Videotext und VPS sein. Für DVD wesentlich interessanter ist dagegen WSS und Closed Captioning.

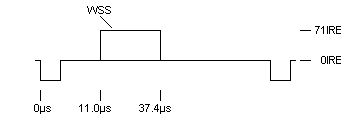

WSS – Wide Screen Signaling

|

| Signalform WSS-Signal |

WSS dient zum Kennzeichnen vom Bildformat und zur automatischen Umschaltung von anamorphen Video. WSS ist nur für PAL und SECAM vorgesehen und wird in der ersten Hälfte von Zeile 23 untergebracht. Leider ist die Dokumentation, die ich bisher darüber gefunden habe, nicht besonders ausführlich, so daß einige Punkte nicht ganz geklärt werden können.

WSS besteht aus 137 Elementen (nicht Datenbits), die entweder 0V oder 0.5V über dem Schwarzpegel sind, also 0IRE oder 71IRE. Jedes Element hat eine Dauer von 0.2µs = 200ns. Das gesamte WSS-Signal hat eine Dauer von 27.4µs und beginnt 11µs nach dem Beginn des HSync.

Die ersten 29 Elemente (Run-In) und die folgenden 24 Elemente (Start Code) sind immer gleich:

Run-In = 1 1111 0001 1100 0111 0001 1100 0111 Start Code = 0001 1110 0011 1100 0001 1111

(Die Lücken sind nur der Übesichtlichkeit halber geschrieben, im WSS gibt es keine Lücken, 0 bedeutet 0IRE und 1 bedeutet 71IRE).

Danach folgen die Datenbits b0…b13, jedes Bit wird durch 6 Elemente dargestellt (macht zusammen 84 Elemente):

Bit "0" = 000111 Bit "1" = 111000

Die Datenbits sind in vier Gruppen eingeteilt:

Group1 (Aspect Ratio) b3…b0

| b3-b0 | Format | Position | Active Lines | Mindestanforderung für 16:9 TVs |

|---|---|---|---|---|

| 1000 | 4:3 (a <= 1.46) full format |

– | 576 | mittig mit schwarzen Balken rechts und links |

| 0001 | 14:9 (1.46 < a <= 1.66) letterbox |

center | 504 | mittig mit schwarzen Balken rechts und links oder hor. bis zur vollen Breite gestreckt |

| 0010 | 14:9 (1.46 < a <= 1.66) letterbox |

top | 504 | mittig mit schwarzen Balken rechts und links oder hor. bis zur vollen Breite gestreckt |

| 1011 | 16:9 (1.66 < a <= 1.90) letterbox |

center | 432 | Bildschirmfüllend aufgezoomt |

| 0100 | 16:9 (1.66 < a <= 1.90) letterbox |

top | 432 | Bildschirmfüllend aufgezoomt |

| 1101 | >16:9 (a > 1.90) letterbox |

center | – | bis zur vollen Breite aufgezoomt oder bis zur vollen Höhe aufgezoomt und seitlich abgeschnitten |

| 1110 | 14:9 (1.46 < a <= 1.66) full format |

center | 576 | wahrscheinlich 4:3 open Matte, wird wie 14:9 letterbox dargestellt |

| 0111 | 16:9 anamorph full format |

– | 576 | Bild wird auf 16:9 gestaucht und bildfüllend dargestellt |

Die jeweils ersten Alternativen bei den Mindestanforderungen sollten unbedingt bevorzugt werden, sonst hat man verzerrte Bilder oder fehlende Bildteile. Also beim Kauf eines 16:9-Fernsehers darauf achten, daß er wie gewünscht arbeitet.

Letterbox center bedeutet, daß die Zeilen mit Bildinhalt mittig in den 576 Zeilen liegen. Top bedeutet, daß der Bildinhalt mit der ersten der 576 Zeilen beginnt. Ein 16:9-Fernseher muß beim Zoomen entweder die Mitte oder den oberen Teil beim Zoomen auf den Bildschirm bringen.

Group2 (Enhanced Services) b7…b4

Die Bits haben folgende Bedeutung

| b4 | Format |

|---|---|

| 0 | camera mode (jedes Halbbild enthält neue Bewegungsphase) |

| 1 | film mode (je zwei Halbbilder kommen vom selben Bild |

Siehe näheres bei „digital Video“ im Kapitel progressive Scan.

| b5 | Format |

|---|---|

| 0 | normales PAL |

| 1 | clean-PAL (modifiziertes PAL mit besserem Cross-Color) |

| b6 | Format |

|---|---|

| 0 | no Helper-Signal |

| 1 | Helper-Signal (für anamorpes Fernsehen, nicht mit anamorph für DVD verwechseln) |

| b7 | Format |

|---|---|

| – | reseved (sollte auf Null stehen) |

Group3 (Subtitles) b10..b8

| b8 | Format |

|---|---|

| 0 | keine Untertitel im Videotext |

| 1 | Untertitel im Videotext |

| b10-b9 | Format |

|---|---|

| 00 | keine Untertitel |

| 01 | Untertitel im sichtbaren Bildteil |

| 10 | Untertitel außerhalb des sichtbaren Bildteiles |

| 11 | reserved |

Group4 (Reserved) b13..b11 Alle Bits sind „reserved“ und sollten auf Null stehen.

b11 kann inoffiziell als Surround-Status benutzt werden:

| b11 | Format |

|---|---|

| 0 | kein Surround Sound |

| 1 | Surround Sound |

PAL-Plus ist 16:9 letterboxed, mit Helper-Signal und clean-PAL. Auch Filme mit einem Seitenverhältnis von z.B. 2.35:1 werden so gekennzeichnet. PAL-Plus ist die anamorphe Fernsehvariante, das auf einem normalen Fernseher wie ein normales Letterbox-Video aussieht.

16:9 full format anamorph kommt dagegen aus einem DVD-Player: ein 16:9 Videobild wird vertikal um 4/3 gestreckt und so als 4:3-Signal ausgegeben. Ohne einen Fernseher mit anamorpher Umschaltung sieht man dann die berühmten „Eierköpfe“, das Bild ist vertikal gestreckt.

Einige der „reserved“ Bits werden jetzt auch für Kopierschutzzwecke mißbraucht, es soll ähnlich wie beim digitalen Kopieren von CD eine Kopie vom Original möglich sein, jedoch von diesen Kopien nicht mehr. Das soll bei Video jedoch schon auf analoger Seite so ablaufen (digitale Kopien sollen nie zulässig sein). Ebenso kann man Kopien auch sofort ganz unterbinden. Das Ganze soll bei digitalen Videorecordern realisiert werden, ob das bei DVHS, oder Sonys digitalen Camcordern (wenn sie denn auch Eingänge haben) schon so ist, weiß ich leider nicht. Leider habe ich keinerlei detaillierte Informationen darüber finden können, sobald ich neue Erkenntnisse habe, werden sie in dieses Kapitel einfließen. Ich nehme mal an, daß kein Kopierschutz wirksam ist, wenn alle reserved Bits auf Null sind. Bei ARD und ZDF sollen b12 und b13 gelegentlich mal auf „1“ gesetzt worden sein (habe ich selbst noch nicht feststellen können), vielleicht hat man da schon Experimente mit diesem Kopierschutz (nicht wirksam bei analogen VHS-Recordern) gemacht???

Schöne Zukunftsaussichten! Irgendwann werden wohl sogar die analogen VHS-Recorder (wenn es sie dann noch gibt) das WSS auswerten. Für Erbauer von entsprechenden Codeknackern tut sich sicher wieder ein neuer Markt auf.

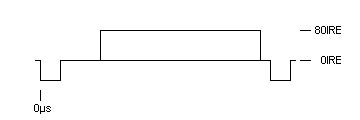

Closed Captioning

Closed Captioning (CC) dient zur Übertragung von Untertiteln auf analogen Videosignalen. Im Gegensatz zu Videotext ist das Signal so aufgebaut, daß es auch noch auf einer VHS-Aufnahme auswertbar bleibt, dafür werden aber wesentlich weniger Daten übertragen. Man benötigt einen speziellen Decoder, der die CC-Daten in das Videosignal einsetzt. Bei DVD wird CC nur selten verwendet, da es dort ja bereits Untertitel gibt. Manchmal hat man aber nur die alten Videomaster genommen und keine DVD-Untertitel eingesetzt, dann kann wenigstens noch CC vom Videomaster dabei sein.

|

| Signalform Closed Captioning (PAL-Timing) |

In jedem Halbbild wird je einer Zeile in der Austastlücke als Datenzeile benutzt. Bei 625/50 (PAL) sind das die Zeilen 22 und 335, bei 525/60 (NTSC) die Zeilen 21 und 284. Basis für das Timing ist die 32-fache Zeilenfrequenz, bei PAL also 500KHz und bei NTSC 503.5KHz. Ein Zyklus dauert also 2µs/1.986µs. Ca. 10.5µs nach dem Beginn des HSync folgen 7 Cos-Zyklen als Timingreferenz. Die nächsten 2 Zyklen sind bei 0IRE. Danach folgen 17 Bits, „0“ entspricht 0IRE, „1“ entspricht 50IRE, bei NTSC gibt es keinen Setup. Die Timingreferenz liegt so, daß deren fallende Flanken im ganzzahligen Zyklus-Zeitraster mit den Zeitpunkten liegen, in denen die Datenbits wechseln. Das erste Bit ist das Startbit (S) und immer „1“, es folgen zwei 7-Bit Worte (LSB zuerst, D0-D6) mit jeweils anschließendem Parity-Bit (P). Das Parity-Bit wird so gewählt, daß die Zahl der „1“-Bits des 7-Bit Wortes und des Parity-Bits ungerade ist (Odd Parity).

Die Daten sind für PAL und NTSC identisch, das Timing weicht aber geringfügig voneinander ab. Normalerweise sollte ein Closed Captioning Decoder mit beiden Formaten fertig werden, ältere Geräte können evtl. Probleme mit einer der beiden Normen haben.

Es gibt einen Text- und einen Captionig-Mode. Im Textmode werden 15 Zeilen mit je 32 Zeichen übertragen und dargestellt, im Captioning werden nur Zeile 1-4 und 12-15 genommen. Der Codesyntax ist sehr umfangreich, es gibt Steuersequenzen für diverse Scrollmodi, Darstellungsarten, Farben, Programmart (Action, Sport, Western…), Programm-Rating (Altersfreigabe), userdefinierte Zeichen und vieles mehr. Offizielle Doku gibt es bei FCC und EIA-608. Vieles wird auch im Buch „Video demystified“ von Keith Jack beschrieben.

VITC Timecode

Mit dem Timecode wird jedes einzelne Bild durchnumeriert, so daß eine bildgenaue Nachbearbeitung möglich wird. Alle Profikameras und auch einige Camcorder zeichnen einen Timecode zusammen mit dem Video auf, meistens ist das VITC. Schnittgeräte lesen beim Abspielen den Timecode und können so exakte Videoschnitte durchfühern.

|

| Signalform VITC |

VITC-Timecode wird in der vertikalen Austastlücke eines jeden Halbbildes eingesetzt. Bei 625/50 (PAL) werden in jedes Halbbild zwei gleiche nicht direkt aufeinanderfolgende Zeilen von 6 bis 22 bzw. 319 bis 335 eigesetzt, bei 525/60 (NTSC) werden normalerweise nur Zeile 11 und 274 genutzt. Jede dieser Zeilen enthält 90 Bits. Jedes Bit dauert bei PAL 0.5517µs, bei NTSC 0.5587µs. Das erste Bit kommt 11.2µs (21 Bits, PAL) bzw. 10µs (19 Bits, NTSC) nach dem Beginn des HSync. Die 90 Bits ergeben 9 Bytes mit je zwei Syncbits davor:

Byte = "1","0",b0,b1,b2,b3,b4,b5,b6,b7

das LSB (Bit 0) kommt zuerst, MSB (Bit 7) zuletzt, genau wie bei einer RS232 seriellen Verbindung. Die Bytes haben folgende Bedeutung:

PAL:

| Byte | Bit 7 | Bit 6 | Bit 5 | Bit 4 | Bit 3 | Bit 2 | Bit 1 | Bit 0 |

|---|---|---|---|---|---|---|---|---|

| Byte 0 | User | Frame Einer | ||||||

| Byte 1 | User | col F | 0 | Frame Zehner | ||||

| Byte 2 | User | Sekunden Einer | ||||||

| Byte 3 | User | 0 | Sekunden Zehner | |||||

| Byte 4 | User | Minuten Einer | ||||||

| Byte 5 | User | 0 | Minuten Zehner | |||||

| Byte 6 | User | Stunden Einer | ||||||

| Byte 7 | User | field | 0 | Stunden Zehner | ||||

| Byte 8 | Check Sum | |||||||

col F: color frame flag, ist gesetzt, wenn der Timecode fest mit der Phasensequenz der PAL-Bursts gekoppelt ist, diese Phasensequenz wiederholt sich alle 8 Halbbilder.

field: field mark flag, „0“ = odd-field, „1“ = even-field (siehe Kapitel „Videosignal und Synchronisation“)

NTSC:

| Byte | Bit 7 | Bit 6 | Bit 5 | Bit 4 | Bit 3 | Bit 2 | Bit 1 | Bit 0 |

|---|---|---|---|---|---|---|---|---|

| Byte 0 | User | Frame Einer | ||||||

| Byte 1 | User | col F | drop F | Frame Zehner | ||||

| Byte 2 | User | Sekunden Einer | ||||||

| Byte 3 | User | field | Sekunden Zehner | |||||

| Byte 4 | User | Minuten Einer | ||||||

| Byte 5 | User | 0 | Minuten Zehner | |||||

| Byte 6 | User | Stunden Einer | ||||||

| Byte 7 | User | 0 | 0 | Stunden Zehner | ||||

| Byte 8 | Check Sum | |||||||

col F: color frame flag, ist gesetzt, wenn der Timecode fest mit der Phasensequenz der NTSC-Bursts gekoppelt ist, diese Phasensequenz wiederholt sich alle 4 Halbbilder.

field: field mark flag, „0“ = odd-field, „1“ = even-field (siehe Kapitel „Videosignal und Synchronisation“)

drop F: „0“ = kein Frame dropping, „1“ = Frame dropping (siehe weiter unten)

Die User-Bits können beliebig genutzt werden. Es werden immer Vollbilder durchnumeriert, auch wenn wie bei einer elektronischen Kamera keine progressive Quelle vorliegt. Das Schema ist HH:MM:SS:BB mit HH = Stunde, MM = Minute, SS = Sekunde, BB = Bild-nr. in dieser Sekunde. Die einzelnen Ziffern werden BCD-codiert:

Ziffer Bits 0 0000 1 0001 2 0010 3 0011 4 0100 5 0101 6 0110 7 0111 8 1000 9 1001

Da die Zehnerziffern nur bis 2 oder 5 gehen, bleiben Bits frei, die dann anderweitig verwendet werden wie z.B. das field mark flag.

Es wird die 24-Stunden Uhr benutzt (00:00:00 – 23:59:59), BB läuft bei PAL von 0 bis 24 und bei NTSC von 0 bis 29. Je ein Odd- und das darauffolgende Even-Field erhalten die gleiche Nummer, mit dem Bit „field“ werden sie dann unterschieden.

Bei NTSC gibt es noch die Möglichkeit des Frame-dropping: Da die Bildwechselfrequenz bei NTSC nicht genau 60Hz beträgt, sondern 59.94Hz, geht die „Uhr“ des Timecodes etwas nach. Zum Ausgleich werden bei eingeschaltetem Frame-droppig einige Frames (je ein Odd- und das darauffolgende Even-Field) weggelassen und zwar die ersten zwei Frames in jeder Minute, außer in den Minuten 0, 10, 20, 30, 40 und 50. Dadurch läuft die Uhr dann im Mittel wieder richtig. Bei abgeschaltetem Frame-dropping hat jede Sekunde 30 Frames und die Uhr geht dann eben etwas nach. Zum Schneiden ist das oft die einfachere Methode, da dürfte die kleine Zeitabweichung nicht stören.

Die Prüfsumme (Check Sum) errechnet sich wie folgt:

CRC = ( Byte0

^ (Byte1 << 2) ^ (Byte1 >> 6)

^ (Byte2 << 4) ^ (Byte2 >> 4)

^ (Byte3 << 6) ^ (Byte3 >> 2)

^ Byte4

^ (Byte5 << 2) ^ (Byte5 >> 6)

^ (Byte6 << 4) ^ (Byte6 >> 4)

^ (Byte7 << 6) ^ (Byte7 >> 2)

^ 0x40) & 0xFF;

|

| VITC Prüfsummengenerierung |

d.h. Byte 1, 2, 3, 5, 6 und 7 werden um je 2,4 bzw. 6 Bits rotiert (die Bits, die links herausgeschoben werden, kommen rechts wieder in das Byte hinein), dann werden alle Byte miteinander exclusiv-oder verknüpft und schließlich noch das b6 umgedreht. Diese merkwürdige CRC-Berechnung ergibt sich aus der ursprünglichen CRC-Hardware, bei der alle 90 Bits inclusive der Startbits durch ein rückgekoppeltes Schieberegister laufen, danach steht die Prüfsumme im Schieberegister.

Videorecorder

Hier sollen einige kurze Anmerkungen genügen. Die Bandbreite, die auf einem Band aufgezeichnet werden kann, hängt von der Bandgeschwindigkeit ab. Für Videosignale braucht man eine sehr hohe Bandgeschwindigkeit. Mit normaler Tonbandtechnik ist das nicht zu realisieren. Neben den Problemen der Geschwindigkeit wäre auch jedes noch so dünne Tonband auf noch so großen Spulen in wenigen Minuten durchgelaufen. Die Basisidee wurde für professionelle Videorecorder gefunden: man nimmt ein breites Band und bespielt es quer. Eine rotierende Trommel bewegt die Magnetköpfe quer zur Bandrichtung, das Band bewegt sich dabei langsam weiter, so daß es quasi „zeilenweise“ beschrieben wird. Durch die Rotation der Kopftrommel erhält man die hohe relative Bandgeschwindigkeit, nicht das Band sondern die Köpfe bewegen sich schnell. Bei VHS werden die Spuren schräg aufgezeichnet, so sind sie länger (dann paßt ein komplettes Halbbild auf so eine Spur) und die Kopftrommel braucht nur zwei Köpfe.

Da Tonbandaufzeichnungen keine Gleichspannung aufzeichnen können, wird eine Trägerfrequenz mit dem Videosignal frequenzmoduliert (FM) und dann erst aufs Band aufgezeichnet Damit wird ein Frequenzbereich von ca. 1MHz bis 4MHz belegt . Wegen der begrenzten Bandbreite geht dabei die Farbe verloren. Das Farbsignal wird deshalb auf 627KHz umgesetzt und so auf das Band gebracht. Bei der Wiedergabe wird das FM-Signal wieder demoduliert, das Farbsignal wieder auf die Farbhilfsträgerfrequenz umgesetzt und entweder getrennt (Y/C) oder gemeinsam (FBAS) ausgegeben. Der Ton wird einerseits wie bei einem Cassettenrecorder auf einer Randspur aufgezeichnet (das ist der erbärmliche Linearton) und bei HIFI-Videorecordern FM-moduliert und wie das Videosignal im Schrägspurverfahren aufgezeichnet. Dabei liegen die Tonspuren „unter“ dem Videosignal, d.h. erst wird der HIFI-Ton bespielt und kurz darauf zeichnet der Videokopf an der gleichen Stelle das Videosignal auf. Durch unterschiedliche Frequenzbereiche und unterschiedliche Winkel der Kopfspalte für Ton und Bild kann man das wieder trennen.

Analoger Kopierschutz

Kaum hatten sich Videorecorder und Videotheken etabliert, gefiel das der Filmindustrie nicht. Neben einigen kuriosen und ärgerlichen Zwischenfällen wie z.B. eingeblendete Logos oder sogar Laufschriften mitten im Film quer durchs Bild (das macht VCL auf ihren Videos wie z.B. bei „Cube“ auch heute, Anfang 2001 noch) wurde dann klammheimlich ein Kopierschutz für Video eingeführt. Es wurde ein nicht-normgerechtes Videosignal aufgezeichnet, das von Videorecordern zwar abgespielt und von Fernsehern verarbeitet werden kann, das aber nicht aufgenommen werden kann. Soweit die Theorie.

Der Filmindustrie muß schon damals klar gewesen sein, daß man professionelle Videopiraten damit nicht aufhalten kann, schon damals sollte nur der kleine Privatmann(-frau) bevormundet werden. Um es einmal ganz klar zu sagen: Kopien für den privaten Eigenbedarf sind ausdrücklich erlaubt, auch von geliehenen Videos (von selbst geliehenen, man darf ebenso wie der Nachbar keine geliehenen Videos weiterverleihen). Ob da ein technischer Kopierschutz vorhanden ist oder nicht, ob der erst geknackt werden muß oder man mit passenden Geräten noch Glück hat, das hat juristisch keinerlei Einfluß. Strafbar mach man sich erst, wenn man Kopien weitergibt oder weiterverleiht, unabhängig vom Kopierschutz. Kopierschutz ist lediglich eine Vereinbarung zwischen Herstellern und Filmindustrie!

UPDATE: ab 1.8.2003 gilt ein Verbot zum Umgehen von Kopierschutz. Privat wird wohl von einer Strafverfolgung abgesehen, aber es bleiben immer noch (unrealistisch hohe!) Schadenersatzansprüche der Filmindustrie…

Grundidee

Es zeigt sich schnell, daß auch einige Fernseher, besonders die mit Digitaltechnik oder mit zusätzlichen Features wie Bild im Bild (es gab auch analoge Lösungen mit Eimerkettenspeichern) gestört wurden, andererseits zeichneten recht viele Videorecorder das Signal trotzdem ohne oder mit nur geringen Störungen auf. Das erste Problem kümmerte die Väter des Kopierschutzes so gut wie gar nicht, wohl aber das zweite. So änderte der VHS-Lizenzinhaber JVC kurzerhand die Spezifikation für Hersteller, so daß alle ab dann gebauten Geräte die kopiergeschützten Videos garantiert nicht mehr aufzeichneten. Betamax, V2000 und V8/HI8 ließen sich zunächst davon nicht beeindrucken, sind aber bis auf V8/HI8 inzwischen vom Markt verschwunden. Bei V8/HI8 und sogar Betamax wurden dann wie bei VHS die Specs ebenfalls von den Lizenzinhabern geändert und ab dann reagierten auch die Recorder nach Wunsch der Kopierschutzmacher.

Da ab 1.8.2003 auch das Veröffentlichen von Anleitungen zum Umgehen von Kopierschutz verboten ist, habe ich die technischen Beschreibungen zum Kopierschutz entfernt. Irgendwelche auf Abmahnungen spezialisierten Anwälte könnten sonst evtl. eine Anleitung zum Bau eines Kopierschutzknackers darin sehen. Leider muß man jetzt auch alle Heimkinobesitzer im Stich lassen, die wegen des Kopierschutzes Probleme haben (Helligkeitspumpen bei einigen Projektoren oder Scalern/Linedoublern usw.)

Daher bleiben nur noch die Beschreibungen der möglichen Bildstörungen des Kopierschutzes:

Durch Manipulationen der Synchronisation entsteht das berüchtigte Helligkeitspumpen, auch auf manchen Fernsehern und Projektoren.

Natürlich dauerte es nicht lange und die ersten Kopierschutzkiller kamen auf den Markt. Hersteller waren durchweg kleine Firmen, die keine VHS-Lizenz zu verlieren haben…

Updates

Kaum gab es die ersten Kopierschutzknacker, gab es auch schon die ersten Updates des Kopierschutzes. Die echten, normalen Syncsignale wurden etwas abgeschwächt. Neben anderen Manipulationen ist das vor allem für viele Fernseher, besonders mit digitaler Bildverarbeitung, ungünstig, sie gehen von einem zu hohen Schwarzpegel aus und zeigen mit Kopierschutz ein dunkleres Bild als ohne. Besonders ärgerlich für denjenigen, der seine Anlage mit Hilfe von Testbildern mühsam eingestellt hat. Aber solche Probleme interessieren die Filmindustrie wenig…

Richtig von Erfolg war diese Maßnahme nicht gekrönt, in kürzester Zeit gab es auch Updates für die Kopierschutzknacker, die größeren Probleme mit der Bildqualität bleiben aber auch damit erhalten…

Neben einigen weiteren Kleinigkeiten konnte man aber keine weiteren Manipulationen am Videosignal vornehmen, so daß mit den letzten Kopierschutzknackern der Kopierschutz entgültig ausgehebelt wurde. Oder etwa doch nicht???

Manipulation des Farbsignales

Mit dem Kopierschutz für VHS-Video war entgültig das Ende der Fahnenstange erreicht. Mit Aufkommen von DVD und digitalen Settop-Boxen für Pay-TV ergab sich jedoch eine neue Möglichkeit. Da dort das Videosignal erst im D/A-Wandler erzeugt wird, konnte man nun auch das Farbsignal manipulieren (bei Videoaufnahmen ist das nicht möglich).

Diese Störungen befinden sich im FBAS-Signal und bei Y/C im C-Signal. Bei YUV und RGB gibt es kein moduliertes Farbsignal und damit auch nicht diese Störungen. Also Finger weg von FBAS und Y/C, stattdessen lieber den RGB- oder YUV-Anschluß verwenden, neben der prinzipiell besseren Bildqualität erspart man sich wenigstens diesen Teil der Bildstörungen – ganz legal.

Völlig immun gegen den Kopierschutz wird man, wenn man ein professionelles Videosystem hat, das das Videosignal aufbereitet, bis nur noch der sichtbare Bildinhalt als YUV oder RGB vorhanden ist und dieses dann wieder neu zu einem sauberen Y/C- oder FBAS-Signal aufbereitet. Wenn diese Geräte vom Kopierschutz am Eingang nicht gestört werden, hat man für immer Ruhe. Digitale Systeme für die Videoverarbeitung, Timebase-Corrector-Geräte (siehe Video digital) und ähnliches aus dem Profi-Bereich arbeiten genau so.

Testbilder

Testbilder dienen zum Einstellen und Überprüfen der gesamten Videohardware. Viele Testbilder sind für die visuelle Beurteilung, andere liefern spezielle Signale für Meßgeräte wie Oszilloskop oder Vektorskop.

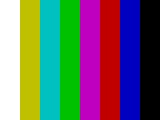

Farbbalken

|

| Testbild Farbbalken |

Alle sichtbaren Zeilen haben den gleichen Bildinhalt. Auf dem Oszilloskop sieht man dann ein Bild wie im Kapitel „PAL“ oder „NTSC“. Es ist 100% Weiß (100IRE), die übrigen Farben haben 75% Helligkeit.

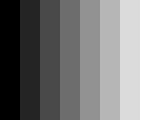

Farbreinheit

|

| Testbild Farbreinheit |

Mit Farbreinheit wird das „Übersprechen“ der Grundfarben Rot, Grün und Blau untereinander bezeichnet. Wenn z.B. der „rote“ Elektronenstrahl in der Bildröhre nicht nur die roten, sondern auch die grünen oder blauen Leuchstoffpixel trifft, hat man Farbverfälschungen. Das passiert, wenn äußere Magnetfelder einwirken (z.B. nicht abgeschirmter Sub unter dem Fernseher) oder wenn die Ablenkeinheit dejustiert ist. Das Bild ist komplett rot, da die rote Leuchtschicht den kleinsten Wirkungsgrad hat und damit der „rote“ Elektronenstrahl am stärksten ist. So macht sich bei einem roten Bild eine mangelhafte Farbreinheit am schnellsten bemerkbar.

Grautreppen

|

| Testbild Grautreppe |

|

| Testbild Grautreppe fein |

Mit Grautreppen kann auf dem Oscilloskop die Linearität der Videoelektronik überprüft werden und Helligkeit und Kontrast eingestellt werden. Für die Linearität ist die grobe Grautreppe günstig, für die Einstellung dagegen die doppelte feine Grautreppe. Helligkeit und Kontrast sind dann optimal eingestellt, wenn alle Stufen der Grautreppen gut voneinander zu unterscheiden sind, jedoch bei geringer Erhöhung oder Erniedrigung der Helligkeit die hellsten bzw. dunkelsten Stufen ununterscheidbar werden. Helligkeit und Kontrast müssen dazu wechselseitig eingestellt werden, das ist ziemlich mühsam, aber das Ergebnis ist meistens besser als mit dem Pluge-Testbild.

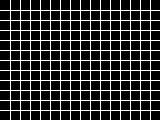

Konvergenz

|

| Testbild Konvergenz |

Mit diesem Gittermuster kann man die genaue Deckung der drei Grundfarben überprüfen und einstellen. Bei Abweichungen decken sich die roten, grünen und blauen Linien nicht ganz und zeigen Farbstreifen oder liegen sogar rot, grün und blau nebeneinander. Der Konvergenzabgleich ist nötig bei Farbfernsehern und Röhrenprojektoren, bei LCD, DLP, Plasmaschirmen und Laserprojektoren nicht. Bei LCD und DLP mit je drei Chips ist dagegen eine Konvergenzeinstellung wieder nötig.

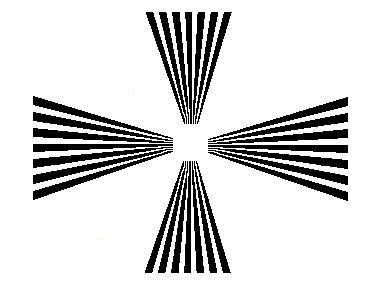

Auflösung

|

| Testbild Auflösung |

Die Balken werden zur Mitte hin immer schmaler, genau so wie die Abstände, die genau so breit wie die Balken selbst sind. Irgendwann können die Balken nicht mehr voneinander getrennt werden. An dem Punkt ist dann die vertikale oder horizontale Auflösungsgrenze erreicht. Dies Bild hier ist nur ein grobes Beispiel, bei den richtigen Bildern sind die Balken feiner und mit Markern versehen, an denen man die jeweilige Auflösung ablesen kann.

Anti PAL

|

| Testbild Anti-PAL |

Im gesamten Bild beträgt die Helligkeit exakt 50%, also Y = 0.5. In der linken Hälfte ist in jeder Zeile abwechselnd

U = +0.25 und U = -0.25 und V = 0.

In der rechten Hälfte ist in jeder Zeile abwechselnd

V = +0.25 und V = -0.25 und U = 0.

Ein PAL-Farbdecoder bildet immer den Mittelwert zwischen der aktuellen und der vorhergehenden Zeile. Bei diesem Anti-PAL Testbild hebt sich bei exakt eingestelltem Farbdecoder die Farbe in beiden Feldern komplett auf, sie müssen genau so grau aussehen, wie die graue Umgebung. Lediglich die erste und letzte Zeile von jedem Block blitzt farbig auf, da dort je einmal bei der Mittelwertbildung die entgegengesetzte Zeile als Nachbar fehlt. Das gilt für FBAS oder Y/C. Bei einem RGB- oder YUV-Anschluß sieht das Bild wie hier aus, nur ist jeder Balken in den Blöcken nur je eine (Halbbild-)Zeile breit.

Pluge

|

| Testbild Pluge |

Das Pluge-Testbild ist gut zur Kontrolle des Schwarzwertes und der Fähigkeit des Monitors geeignet, ob geringe Kontraste nahe beim Schwarzwert differenziert wiedergegeben werden. Der Hintergrund ist Schwarz (0IRE). Rechts im Bild ist eine normale Grautreppe (25IRE, 50IRE, 75IRE, 100IRE). Links im Bild sind zwei senkrechte Streifen. Der linke ist ultraschwarz, d.h. etwas „schwärzer“ als Schwarz

(-2IRE), der rechte ist sehr dunkles Grau (+2IRE). Bei einem richtig eingestellten Monitor ist der ultraschwarze Balken nicht zu sehen, der dunkelgraue ist dagegen gut zu erkennen. Bei meinem Bild mußte ich übrigens genau so schummeln, wie das auch bei den meisten Pluge-Bildern auf Test-DVDs gemacht wird: da bei VGA kein Ultraschwarz möglich ist, ist bei mir der Hintergrund nicht schwarz, sonder dunkelgrau. Der linke Balken ist dann normal schwarz und der rechte ist ein etwas helleres Grau wie der Hintergrund. Hier bei meinem VGA-Bild ist der Hintergrund sogar 30, das entspricht ca. 12IRE, der rechte Balken ist sogar auf 60, das entspricht ca. 24IRE. Andernfalls ist bei vielen VGA-Monitoren kaum noch etwas zu erkennen, die sind meistens anders eingestellt als Fernseher, man betrachtet die ja auch nicht im abgedunkelten Raum. Da bei DVD Schwarz den Y-Wert 16 hat, ist ein Ultraschwarz prizipiell möglich, aber viele D/A-Wandler begrenzen das Videosignal auf diesen erlaubten Bereich, so daß ein Ultraschwarz zum normalen Schwarz wird. Bei echten Pluge-Bildern ist dann der ultraschwarze Balken nie sichtbar, auch wenn der Monitor viel zu hell eingestellt ist.

Needle

|

| Testbild Needle |

In der oberen schwarzen Hälfte befindet sich eine senkrechte weiße Linie von einem Pixel Breite. In der unteren weißen Hälfte ist eine gleiche Linie in Schwarz. Auf einem Oszilloskop äußern sich diese Linien als kurze Nadelimpulse, daher auch der Name des Testbildes. Die Höhe der Nadelimpulse muß ebenfalls möglichst genau Weiß- bzw. Schwarzwert erreichen. Nur bei einem korrekten Frequenzgang und nicht zu großen Phasenverzerrungen ist das der Fall.

FBUK

|

| Testbild FBUK |

Dies ist ein Kombinationstestbild zur visuellen Kontrolle. Im Hintergrund ist ein Gittermuster für die Konvergenzkontrolle. In der oberen Reihe sind die Farbbalken 100% Weiß und 75% Gelb, Cyan, Grün, Purpur, Rot, Blau und Schwarz. Darunter ist eine Grautreppe mit 5 Stufen. In der nächsten Reihe ist ein Schwarzkeil, jede Zeile enthält somit einen Nadelimpuls, der von Zeile zu Zeile immer breiter wird. Darunter befinden sich SIN-Pakete: links 1MHz, dann 2MHz und 3MHz zur groben Beurteilung der Auflösung. Die farbige Fläche rechts daneben ist 50% Grau und enthält als Farbinformation genau die gleiche Phase wie der Burst, also 135° für PAL, das entspricht einem Orange-Gelb. In der unteren Reihe ist je eine Fläche, bei der einen ist die Phase im Farbkreis 0° (Blau mit leichtem Touch zum Lila) und 90° (Rot mit Tendenz zum Purpur), die nach rechts hin in der Helligkeit bis nach 0 abnimmt. Auf einem Vektorscop, das nur das Farbsignal in U- und V-Kordinaten darstellt, erscheint dann je eine Linie auf der U- und der V-Achse. Rechts daneben sind zwei graue Quadrate, das sind zwei Anti-PAL Felder, so wie beim Anti-PAL Testbild. Schließlich ist über das ganze Bild noch ein weißer Kreis gelegt, mit dem kann man oft schon mit einem Blick die Bildgeometrie beurteilen.

Zonenplatte

|

| Testbild Zonenplatte |

Mit diesem Testbild kann die richtungsabhängige Auflösung beurteilt werden. Von der Mitte her wird der Abstand der Linien zueinander immer enger. An den roten quadratischen Grenzen beträgt der Abstand von Schwarz zu Schwarz genau 2 Zeilen, also ist dort eine Auflösung von der vollen Zeilenzahl gefordert (siehe Kapitel Meßwerte). Weiter außen werden die Linien noch enger. Dieses Bild zeigt sehr schön auch alle Aliasingeffekte, die bei Video möglich sind. Die 8 Kreise, die auf der roten Umrandung liegen, sind eigentlich gar nicht vorhanden sondern entstehen durch mangelhafte Filerung des Videosignales auf der D/A-Wandlerseite. Vertikal kann man nur etwas tun, wenn die Zeilenzahl des Bildes vervielfacht und dabei gefiltert wird, horizontal genügt ein entsprechender Tiefpaß hinter dem D/A-Wandler. Bei VGA ist so ein Tiefpaß nicht vorhanden, da will man ja eine Pixelstruktur haben. Außerhalb des roten Quadrates ist Aliasing auf der Erzeugerseite vorhanden, dort wird das Abtasttheorem von Shannon verletzt. Bei der Berechnung dieser Zonenplatte wird das mit Absicht so gemacht, um eben dieses Aliasing zu zeigen. Die 8 Kreise am Außenrand sind genau so deutlich wie der in der Mitte, obwohl dort der Abstand von Schwarz zu Schwarz genau 1 Zeile beträgt. Genau deshalb sieht man ja auch keine Linienstrukturen mehr, eine Zeile weiter hat man die gleiche Helligkeit.

Wenn der Mittelpunkt die Koordinaten x0, y0 hat, berechnet sich die Helligkeit Y folgendermaßen aus den Pixelkoordinaten x und y: (N ist der Abstand vom Mittelpunkt, wo die max. Auflösung erreicht wird, d.h. der Abstand von Schwarz bis Schwarz ist zwei Pixel)

r² = (x - x0)² + (y - y0)² Y = 0.5 + 0.5 * COS(PI * r² / 2 / N)

Noch interessanter wird die Sache, wenn der Zeilensprung ins Spiel kommt, die vertikale Auflösung sinkt dramatisch, auf etwa 60-70% der Auflösung, die den oberen und unteren roten Linien entspricht. In der Nähe der roten Linien (aber noch innerhalb des Quadrates) überwiegt das 25Hz-Flimmern, die Linien selbst sind kaum noch auseinander zu halten. Gerade mit dieser Zonenplatte sieht man die Vorteile eine progressiven Darstellung sofort.

Bei einem FBAS-Signal erscheinen noch zusätzliche farbige Kreismuster, die Farben sind nicht statisch, sondern laufen ständig nach außen oder innen. Das ist nichts anderes als die Cross-Color Störung, weil dort die Frequenz des Helligkeitssignales in die Nähe der Farbhilfsträgerfrequenz kommt.

Und wieso heißt das Bild Zonenplatte? Wenn Interferenzen zwischen einer Kugelwelle (also ausgehend von einem Punkt) und einer parallelen Wellenfront (also ausgehend von einer weit entfernten Quelle) entstehen, zeigen sie ein ganz ähnliches Bild wie dieses. Man kann das z.B. sehen, wenn auf eine glatte Glasplatte eine nur flach gewölbte Linse oder Glasschale gelegt wird. Um die Berührungsstelle entsteht dann so eine Interferenz, die bei größerer Krümmung der Linse sehr schnell sehr klein wird. Die Zonenplatte als Dia, bei dem die Abstände in der Größenordnung der Wellenlänge des Lichts liegen, wirkt wie eine Linse und zwar als Sammellinse und Zerstreuungslinse gleichzeitig (Prinzip der Hologramme).

Filmtransfer

Die Filmabtastung war in den Anfängen des Fernsehens die erste Möglichkeit, außer mit der Nipkowscheibe an ein Videosignal zu kommen. Die „Live-„Übertragung der Olympischen Spiele Berlin in den 30er Jahren wurde mit normalen Filmkameras gemacht, bei denen der belichtete Film nicht aufgerollt wurde, sondern durch ein Rohr gleich in den Übertragungswagen unter der Kamera, wo er sofort durch eine Entwicklermaschiene und anschließend gleich durch den Filmabtaster lief. Das Videosignal kam dann mit ca. 2 Minuten Verzögerung an den Sender. Ein Mann an der Kamera war übrigens Walter Bruch, der Entwickler des PAL-Systems.

|

| Flying Spot |